ChatGPT是什么?ChatGPT的现状和历史

1、ChatGPT是什么?

ChatGPT的全称是”Conversational Generative Pre-trained Transformer”,其中”Conversational”指的是其有能够进行对话的能力,”Generative”指的是其能够生成自然语言文本,”Pre-trained”指的是其在训练数据上进行了预训练,”Transformer”则是其使用的神经网络架构名称。ChatGPT是由OpenAI开发的一种大型语言模型,旨在理解和生成自然语言文本。其训练数据包括来自各种来源的大量文本语料,包括书籍、文章和网页。

ChatGPT使用一种称为transformer的深度学习算法来分析输入文本并生成响应。Transformer是一种神经网络架构,特别擅长处理顺序数据,如文本。

作为一种语言模型,ChatGPT的主要目标是生成符合上下文和语法正确的响应。ChatGPT可以回答各种主题的问题,并且还可以进行日常对话。

ChatGPT架构的一个独特特征是使用了无监督学习。这意味着ChatGPT不需要明确的指令或标记来学习所使用的数据。相反,ChatGPT通过分析文本中的模式和关系来学习。

总的来说,随着ChatGPT被训练的数据越来越多以及OpenAI研究人员不断改进其架构和算法,ChatGPT的能力也在不断发展。

2、ChatGPT应用的实例

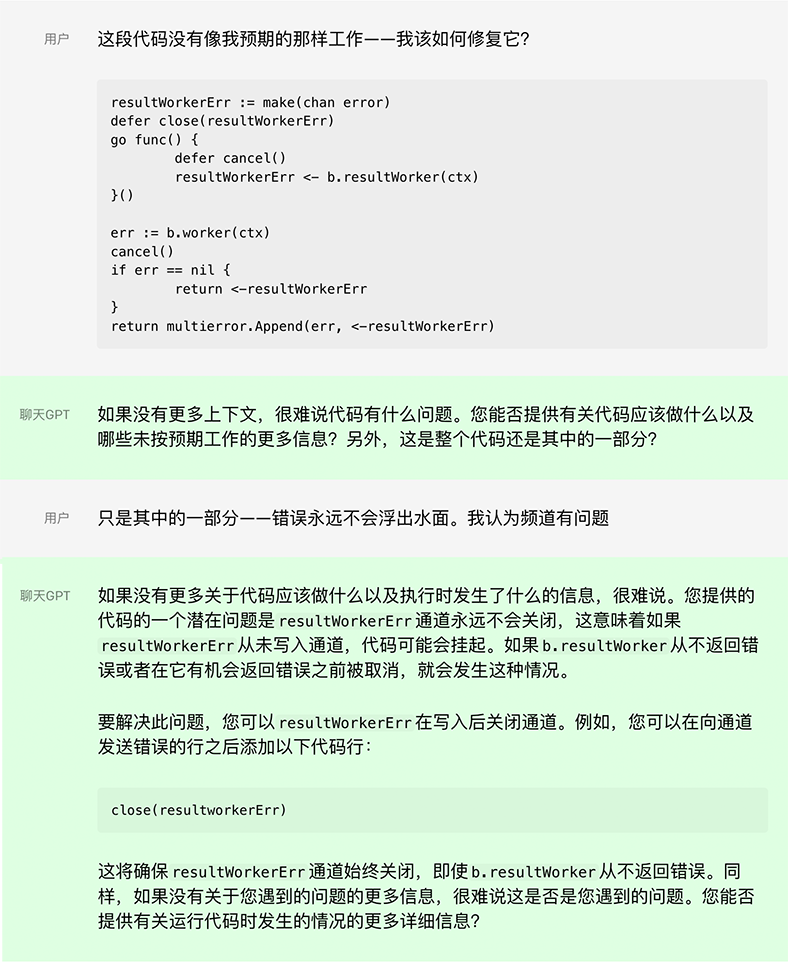

实例1、让ChatGPT检查代码提出问题以帮助调试代码。

程序员使用ChatGPT 时,帮助您以更少的工作量、更快地编写代码。使用 Codex,GitHub Copilot 在您的编辑器中应用上下文并合成整行甚至整个代码的功能。

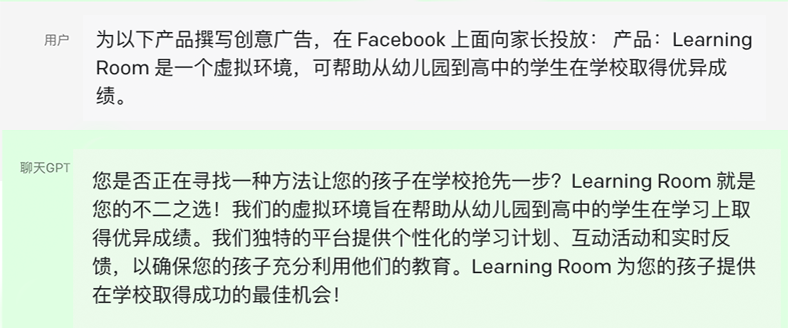

实例2、广告创意-将产品说明变成广告文案。

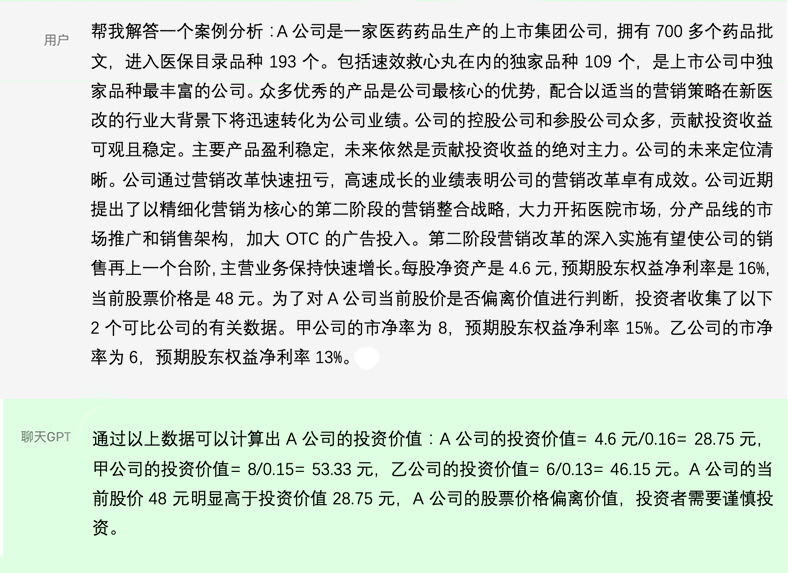

实例3、案例分析也是一把好手!

案例分析只是简单的应用,注意到文中还帮助您完成了相关所需的计算。它还能为研究主题生成大纲,甚至整篇论文。

更多功能与应用查看《ChatGPT能做什么?探索一些示例应用程序》

3、ChatGPT的历史

ChatGPT的历史可以追溯到2018年,当时OpenAI发布了一种名为GPT(Generative Pre-trained Transformer)的语言模型,它是一种在大规模语料库上进行预训练的神经网络架构,可以生成自然语言文本。

随着时间的推移,OpenAI研究人员继续改进GPT,使其能够生成更准确和有逻辑的文本,其中包括GPT-2和GPT-3等不同版本。GPT-2在2019年发布,具有更大的模型规模和更高的生成质量,而GPT-3在2020年发布,拥有数十亿个参数,成为当时最先进的语言模型。

ChatGPT则是基于GPT-3构建的一种具有对话能力的版本,旨在更好地模拟人类的对话交互方式。与之前的版本相比,ChatGPT不仅可以回答问题和生成文本,还可以进行更自然、流畅的对话,并根据上下文生成更符合语境的响应。ChatGPT在2020年底发布,成为当时最先进的聊天机器人之一。

ChatGPT的开发始于2020年初,当时OpenAI的研究人员在GPT-3的基础上添加了一些新的功能,以使其能够更好地模拟对话场景。在这个过程中,他们调整了GPT-3的参数、改进了对话生成的算法,增加了针对对话场景的训练数据,以及优化了交互式响应的性能。

ChatGPT的发布引起了广泛的关注和讨论,许多人对它的语言生成能力和对话交互的流畅性表示赞赏。与此同时,一些人也对其可能带来的潜在危险提出了担忧,例如虚假信息的传播、文本生成的滥用等。

为了缓解这些担忧,OpenAI决定限制ChatGPT的访问,并将其作为一项服务向特定客户提供,这些客户必须经过认证并遵守使用协议。此外,OpenAI还发布了一份”使用和风险考虑”的报告,详细介绍了ChatGPT的潜在应用和可能带来的风险。

总的来说,ChatGPT代表了自然语言生成技术的最新进展,为人们提供了更加智能和自然的对话体验,同时也需要我们认真考虑其使用所带来的风险和责任。

4、ChatGPT的主要目标

ChatGPT的主要目标是创建一个具有更自然、流畅的对话能力的聊天机器人,能够模拟人类之间的对话交互方式,从而更好地服务人类社会。具体而言,ChatGPT的目标包括:

生成更加自然和连贯的文本:ChatGPT使用大规模语料库进行预训练,可以生成高质量的自然语言文本,并且可以根据对话的上下文生成更符合语境的响应。

实现更高质量的对话交互:ChatGPT不仅可以回答问题和生成文本,还可以进行更自然、流畅的对话,可以处理用户的多轮提问和反馈,提供更好的交互体验。

提供更广泛的应用场景:ChatGPT可以被应用于多种领域,例如客服、智能家居、教育、娱乐等,可以为人们提供更加智能化和个性化的服务。

推动自然语言处理技术的发展:ChatGPT是自然语言处理技术领域的最新进展,其研究和应用推动了自然语言处理技术的不断发展和改进。

总的来说,ChatGPT的目标是通过更好的自然语言生成和对话交互能力,为人类社会带来更多的智能化和便利性。

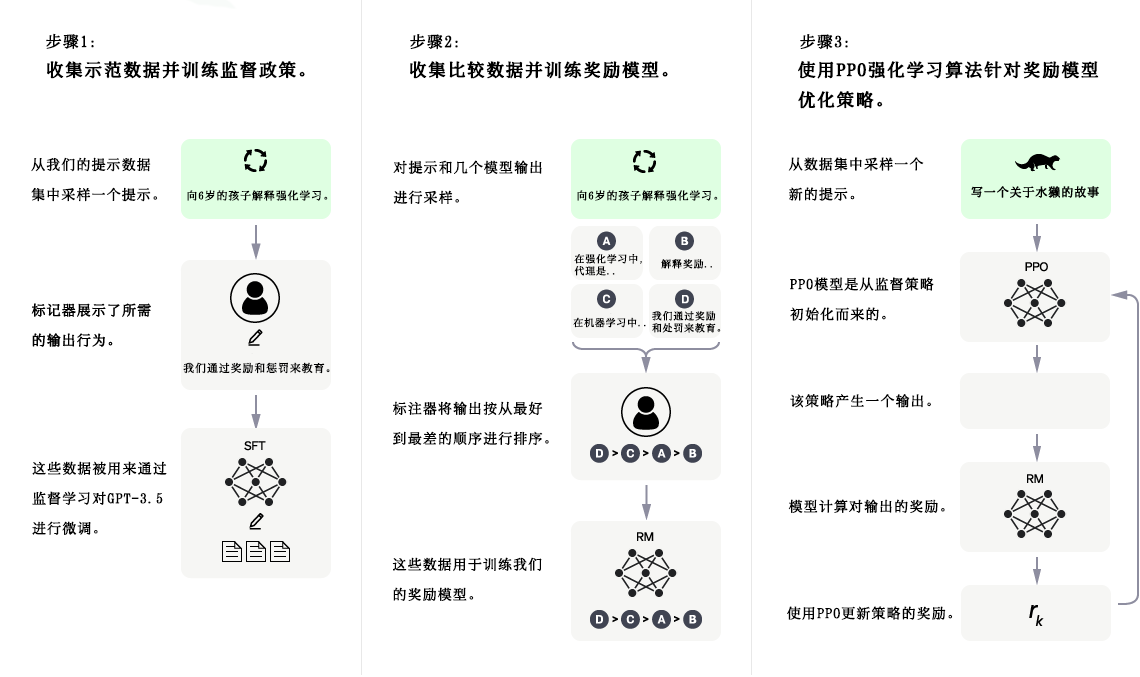

5、的原理和方法

我们使用与InstructGPT相同的方法,使用来自人类反馈的强化学习 (RLHF) 来训练该模型,但数据收集设置略有不同。我们使用监督微调训练了一个初始模型:人类 AI 训练员提供对话,他们在对话中扮演双方——用户和 AI 助手。我们让培训师可以访问模型编写的建议,以帮助他们撰写回复。我们将这个新的对话数据集与 InstructGPT 数据集混合,我们将其转换为对话格式。

为了创建强化学习的奖励模型,我们需要收集比较数据,其中包含两个或多个按质量排序的模型响应。为了收集这些数据,我们收集了 AI 培训师与聊天机器人的对话。我们随机选择了一条模型编写的消息,抽取了几个备选的完成方式,并让 AI 培训师对它们进行排名。使用这些奖励模型,我们可以使用近端策略优化来微调模型。我们对这个过程进行了几次迭代。